Investigadores de Google y el MIT desarrollaron un algoritmo que busca corregir los defectos de las tomas en gran angular.

Quizás hayas visto que los rostros de algunas personas lucen estirados, ligeramente aplastados o con alguna distorsión en las fotografías. Si bien puede ser por las pocas habilidades del fotógrafo, lo cierto es las tomas con el lente gran angular desde dispositivos móviles suelen causar distorsión en los objetos o personas que se encuentran en el borde de la imagen.

Hay diferentes métodos que tratan de solucionar este problema, pero hasta el momento ninguno ha sido tan efectivo como la nueva propuesta de Google. Si bien puede parecer fácil de solucionar, no lo es, ya que requiere una edición local compleja que no afecte el resto de los objetos de la fotografía.

Así funciona el algoritmo de Google

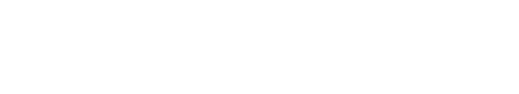

Según explican los investigadores, este algoritmo detecta los rostros y crea como una malla que permite revertir automáticamente este tipo de distorsión al realizar una toma con un gran angular como se ilustra en la imagen:

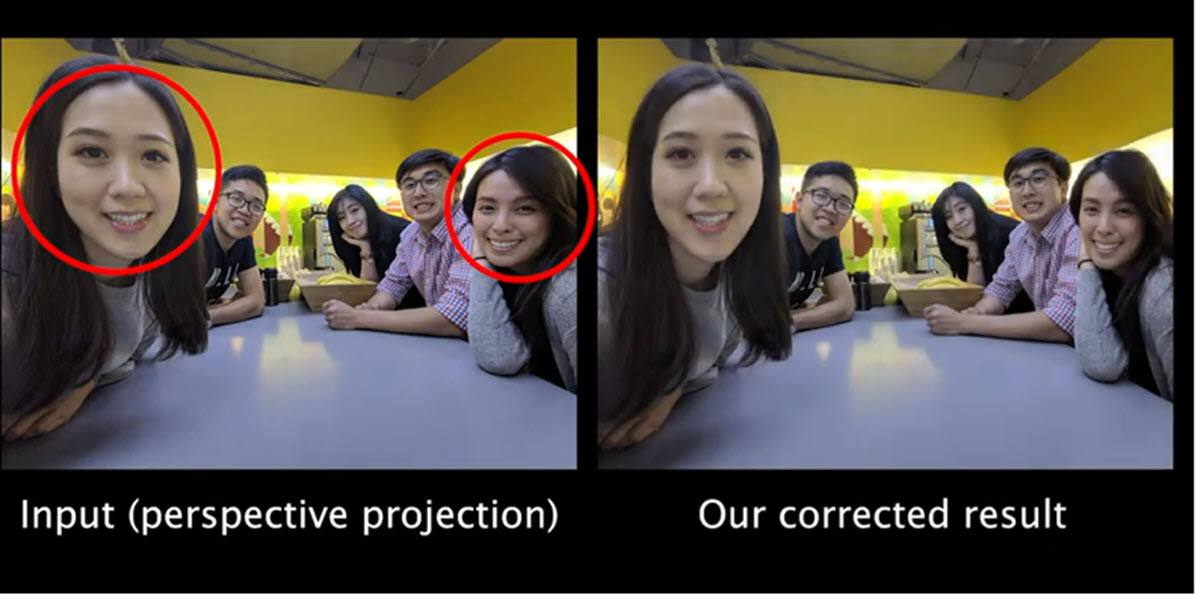

Podemos notar la diferencia al aplicar este algoritmo en las siguientes imágenes. Es una selfie que fue tomada con un lente gran angular con un campo de visión de 97°.

En la primera imagen se ven las distorsiones en los rostros y la segunda muestra cómo el algoritmo restauró las formas de las caras a su estado original.

Es decir, este proceso se activa automáticamente al utilizar el lente gran angular brindando esta asistencia especial a los rostros, pero sin causar modificaciones en el resto de la imagen. Y por supuesto, la velocidad de esta corrección automática (unos 920 milisegundos) hace que sea imposible de detectar por los usuarios.

Según las pruebas que han realizado, este algoritmo funciona de manera exitosa en el rango de 70° a 120° en campo de visión, abarcando casi todas las posibilidades desde un dispositivo móvil.

Para aprovechar el potencial de este algoritmo, el usuario no tendría que realizar ninguna acción ni activar ningún modo de cámara especial. Esta función se implementaría automáticamente solo cuando detecta que se utiliza el lente en gran angular.

Corrección automática teniendo en cuenta el contexto

Podemos ver la dinámica de este algoritmo en el siguiente vídeo:

El algoritmo corrige de manera automática teniendo en cuenta el resto de los objetos que aparecen en escena, logrando que todo el contexto de la fotografía coincida. Los resultados son naturales sin detalles que dejen ver que la fotografía ha sido modificada en absoluto.

El equipo tras este proyecto ha compartido una galería de fotos en Flickr mostrando cómo diferentes métodos abordan este problema en comparación con la dinámica de su algoritmo. Hay más de 160 fotografías (como la que ves al comienzo del artículo) que nos ayudan a evaluar los resultados.

Quizás veamos esta tecnología en el Pixel

Podríamos esperar que este algoritmo o alguna tecnología derivada se aplique en la próxima generación de Pixel, ya que el equipo que participa de este proyecto son empleados de Google.

Sin embargo, en el documento que han compartido, no han mencionado nada al respecto. Estas primeras pruebas del algoritmo en acción han sido exitosas mostrando una vez más cómo el potencial de la inteligencia artificial puede perfeccionar la dinámica de los dispositivos móviles y facilitar la vida de los usuarios.

Ya que sin dudas, contar con una dinámica similar en nuestro dispositivo móvil ahorraría muchos dolores de cabeza y tiempo tratando de editar estas distorsiones en las fotografías.